Nano Banana

Kurzfassung

▾

Quellen

▾

Kling AI hat mit Video O1 das weltweit erste vereinheitlichte Modell veröffentlicht, das Videogenerierung und -bearbeitung in einem einzigen Schritt kombiniert. Nutzer können Szenen, Subjekte und Kameraeinstellungen gleichzeitig per Textprompt ändern, ohne auf Masken oder Keyframes angewiesen zu sein. Das Modell unterstützt bis zu sieben multimodale Eingaben gleichzeitig und liefert Videos in 1080p bei 30fps mit einer Länge von bis zu 10 Sekunden. Video O1 ist ab sofort über die Webplattform von Kling AI verfügbar und für Entwickler exklusiv über die API von fal.ai integrierbar.

Kling AI Official Twitter – Launch Announcement

Kling AI Official Website – Video O1 User Guide

AAStocks – Kuaishou Releases Kling O1

Fal.ai Blog – API Integration

Kling AI hat mit Video O1 das weltweit erste System vorgestellt, das Videogenerierung und -bearbeitung in einem einzigen Modell vereint. Die KI ermöglicht die simultane Anpassung von Szenen, Subjekten und Kameraführung rein über Textbefehle und macht damit komplexe Maskierungsprozesse überflüssig. Vereinheitlichte Architektur statt Pipeline Bisherige KI-Videotools arbeiteten oft in getrennten Schritten oder Pipelines: Erst die Generierung, dann mühsames Inpainting oder separate Upscaling-Prozesse. Kling Video O1 bricht mit diesem Ansatz durch eine sogenannte "Unified Architecture". Das Modell versteht Generierung und Bearbeitung als denselben logischen Prozess. Dies bedeutet, dass das System den Kontext eines Videos nativ begreift. Es ist nicht mehr notwendig, manuell Masken (ausgewählte Bildbereiche) zu zeichnen oder Keyframes (Schlüsselbilder für Start- und Endpunkte) zu setzen, um Veränderungen vorzunehmen. Das Modell interpretiert den Änderungswunsch direkt aus der Texteingabe und wendet ihn nahtlos auf das bestehende Material an.

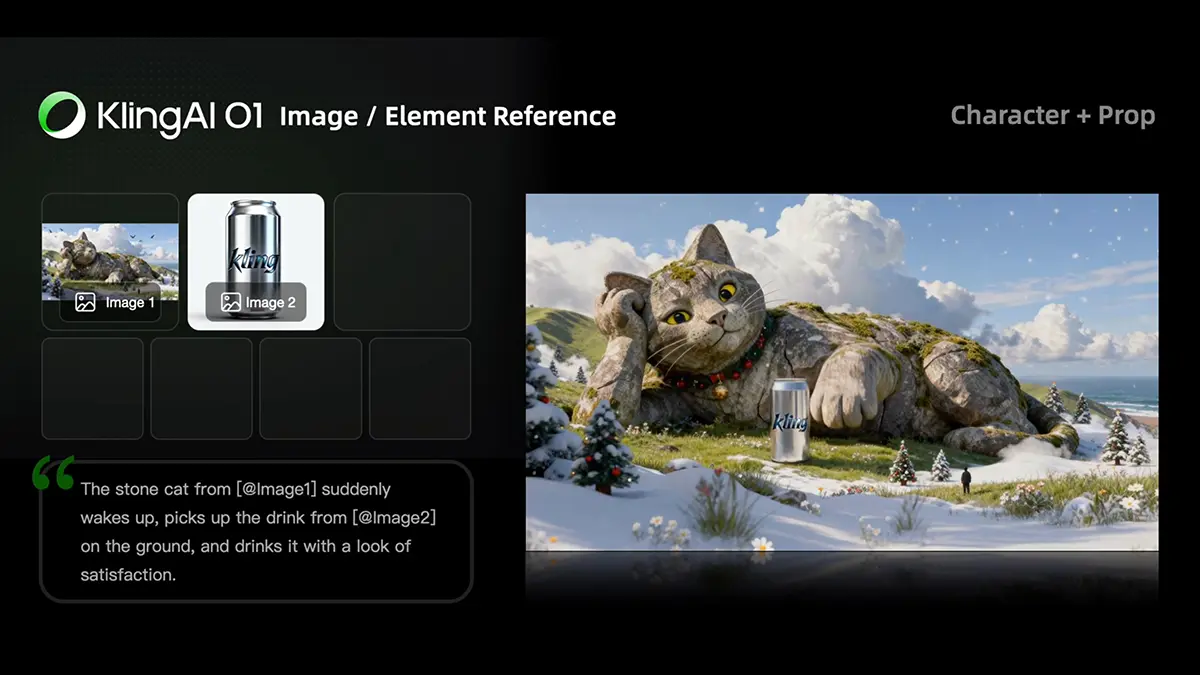

Simultane Kontrolle über alle Elemente Das Alleinstellungsmerkmal von Video O1 ist die Fähigkeit zur parallelen Verarbeitung verschiedener Videoparameter. Nutzer ändern in einem einzigen Arbeitsschritt das Setting, tauschen den Protagonisten aus und passen die Kamerabewegung an. Ein Beispielszenario wäre der Wechsel von einer sonnigen Straße zu einer verregneten Gasse, während gleichzeitig der Darsteller ausgetauscht wird, ohne dass die Kohärenz des Clips verloren geht. Diese simultane Bearbeitung ("Simultaneous Editing") funktioniert, weil das Modell die semantischen Beziehungen zwischen den Objekten versteht. Es weiß, wie sich Lichtverhältnisse auf ein neues Subjekt auswirken müssen, wenn der Hintergrund geändert wird. Das reduziert den Zeitaufwand für iterative Anpassungen erheblich, da nicht mehr Schicht für Schicht gearbeitet werden muss. + Quelle: KlingAI Multimodaler Input für maximale Präzision Kling AI setzt auf eine hohe Bandbreite an Eingabemöglichkeiten, um die Steuerung zu verfeinern. Das System verarbeitet bis zu sieben Eingaben gleichzeitig. Dazu gehören Textprompts, Referenzbilder und existierende Videoclips. Native Auflösung: 720p und 1080p Support. Bildraten: Ausgabe mit 30 Bildern pro Sekunde (fps). Seitenverhältnisse: Flexible Formate wie 16:9, 9:16 oder 1:1. Laufzeit: Generierung von bis zu 10 Sekunden Videomaterial. Diese Multimodalität erlaubt es, den Stil eines Videos durch ein Bild vorzugeben, die Bewegung durch einen Clip zu definieren und den Inhalt per Text zu steuern. Die KI führt diese Informationen zusammen und generiert daraus ein einheitliches Ergebnis. Marktstart und Verfügbarkeit Hinter Kling AI steht der chinesische Tech-Gigant Kuaishou, der mit diesem Release den Druck auf US-Konkurrenten wie Runway und deren Gen-4.5 erhöht. Das Modell ist ab sofort über die Web-Oberfläche von Kling AI verfügbar. Für Entwickler und Integrationen wurde zudem eine exklusive Partnerschaft mit der Plattform fal.ai geschlossen, um Video O1 direkt per API nutzbar zu machen. Ausprobieren kann man es am einfachsten aber direkt über Higgsfield ab heute. ANZEIGE - Neues Kling Modell ausprobieren

Weiterlesen...