Claude Sonnet 4 knackt die Millionenmarke Was bringt der 1M-Token-Kontext für Code, Doku und Agenten – echter Boost oder nur Buzzword? Kurzfassung | Andreas Becker, 13.08.25

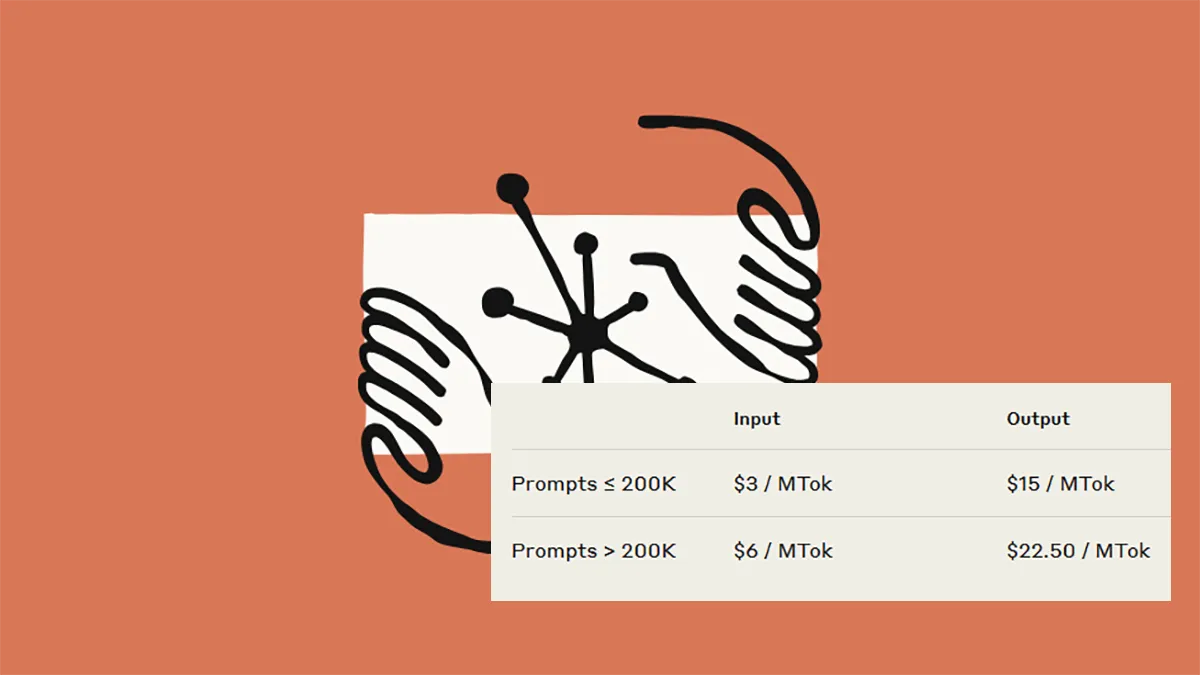

gpt-image-1 | All-AI.de EINLEITUNG Anthropic schaltet Claude Sonnet 4 auf Langstrecke: Ab sofort verarbeitet das Modell bis zu eine Million Token Kontext. Das entspricht Tausenden Seiten Text oder kompletten Code-Repositories – ohne Aufsplitten in Einzelteile. Die Beta startet auf API, Bedrock und bald auch bei Google. Klingt mächtig – doch wie viel davon lässt sich im echten Entwickleralltag tatsächlich nutzen? NEWS Von der Theorie zur Praxis: was 1M Token ermöglichen Der Vorteil eines riesigen Kontextfensters liegt auf der Hand: Statt Code, Dokumentation und Tests einzeln zu füttern, ziehen wir sie jetzt gesammelt ins Modell. Das erlaubt durchgehende Refactorings, ganzheitliche Analysen und eine stabile Übersicht über komplexe Softwarelandschaften. Besonders spannend wird es bei Migrationen, bei denen das Modell Änderungen über mehrere Services hinweg nachvollziehen kann – inklusive Abhängigkeiten, Logs und Schnittstellen. In Forschung und Dokumentenanalyse zeigt sich ähnlicher Nutzen. Wenn Paper, Anhänge und Notizen nicht mehr aufgeteilt werden müssen, bleibt der inhaltliche Zusammenhang stabil. Querbezüge, Argumentationslinien und Metainformationen lassen sich so in einem Schritt verarbeiten – ein Vorteil, den klassische 100K-Modelle bislang nicht liefern konnten. + Quelle: Anthropic - Preise für langen Kontext Verfügbarkeit, Zugang und Preisschild Der 1M-Token-Modus läuft aktuell als Beta – über die Anthropic-API und Amazon Bedrock, Google Vertex AI soll folgen. Zugang gibt es zunächst nur für höhere Nutzungstiers, etwa Tier 4 und Custom-Accounts. Ein breiterer Rollout ist geplant, bleibt aber vorerst Zukunftsmusik. Beim Pricing zieht Anthropic eine klare Linie: Bis 200K Token gelten moderate Preise, darüber wird es teurer – je nach Input- und Output-Größe sogar deutlich. Wer langfristig mit langen Prompts arbeiten will, kommt an Caching und Batch-Verarbeitung kaum vorbei. Diese Optimierungen helfen, die Kosten kalkulierbar zu halten – zumindest für Projekte mit wiederkehrender Struktur. Neue Workflows: Von Review bis Agentenspeicher Gerade in der Codeanalyse entstehen mit 1M Token neue Möglichkeiten. Das Modell kann Tests, alte Commits, Abhängigkeiten und Doku parallel verarbeiten. Für Änderungen an Datenmodellen oder kritischen Schnittstellen bedeutet das: mehr Sicherheit, weniger Trial-and-Error. Unternehmen wie Bolt.new oder iGent AI berichten von stabileren Agentensitzungen, die über Stunden oder sogar Tage hinweg kontextstabil bleiben. Wer „context-aware agents“ aufbauen will – etwa für DevOps, Compliance oder Support – profitiert massiv. Wenn API-Definitionen, Logs, Benutzerverhalten und Tool-Konfigurationen im Langzeitgedächtnis bleiben, sinkt die Fehleranfälligkeit. Das Ergebnis: Agenten, die nicht nur reagieren, sondern proaktiv mitarbeiten können. Ein Blick auf den Wettbewerb – und auf uns Mit dem Schritt auf 1 Mio. Token zieht Anthropic bei einem der zentralen Leistungsmerkmale mit OpenAI gleich. Doch während GPT-4.1 auf 1M schon länger zugreifen kann, punktet Claude jetzt mit besserer Verfügbarkeit und transparenter Preisstruktur – zumindest in der Beta. Für unseren Alltag heißt das: Weniger manuelles Chunking, mehr durchgehende Prompts. Ob das Modell wirklich smarter wird oder nur geduldiger zuhört, hängt vom Use Case ab. Wer Code, Doku oder Logs nicht mehr aufteilen muss, wird den Unterschied schnell merken. Der Kontext ist da – jetzt liegt es an uns, ihn zu nutzen. DEIN VORTEIL - DEINE HILFE Kostenlose News und Tutorials – mit minimaler Werbung und maximalem Mehrwert. Damit das so bleibt und wir uns stetig verbessern können, freuen wir uns über deine Unterstützung. Teile diesen Beitrag Folge uns auf Social Media Keine KI-News mehr verpassen und direkt kommentieren! Mastodon X Bluesky Facebook LinkedIn Youtube Unterstütze uns direkt Mit einer YouTube-Mitgliedschaft (ab 0,99 €) oder einmalig über PayPal. So helft ihr uns, unabhängig neue Tools zu testen und noch mehr Tutorials für euch zu erstellen. Vielen Dank für euren Support! Youtube - Kanal PayPal - Kaffee KURZFASSUNG

Anthropic hat Claude Sonnet 4 mit einem Kontextfenster von 1 Mio. Token ausgestattet – genug für ganze Codebasen und Dokumentationen.

Das ermöglicht tiefere Analysen, durchgängige Agenten-Sessions und neue Workflows für Entwickler und Forscher.

Der Zugang startet als Public Beta über Anthropic API und Amazon Bedrock, allerdings nur für höhere Nutzungstiers.

Mit effizientem Caching und Batch-Verarbeitung kann das Feature trotz hoher Preise echte Arbeitserleichterung bringen.

QUELLEN

Claude Sonnet 4 now supports 1M tokens of context

Anthropic – Pricing

The Verge – Anthropic’s Move in the AI Coding Wars

Amazon Web Services – Claude 4 on Bedrock

Weiterlesen...